在 AI 应用中,LangChain 和 RAG(Retrieval-Augmented Generation,检索增强生成) 各自发挥着重要的作用,经常被结合使用来打造更强大的语言模型应用。让我们逐一拆解它们的作用:

🌐 1. LangChain 的作用

LangChain 是一个用于构建与大型语言模型(LLMs)交互的应用框架。它的主要作用包括:

✅ 链式调用(Chaining):

- 将 LLM 与外部工具、API、数据库等串联起来,执行多步逻辑操作。

- 例如:先用 LLM 生成搜索关键词,再用这些关键词去数据库检索,最后根据检索结果生成回答。

✅ 上下文管理(Memory):

- 帮助模型“记住”对话历史,确保多轮对话保持连贯性。

- 例如:在客户服务场景中,让 AI 记住用户的历史提问,提供更贴心的服务。

✅ 工具集成(Tools & Agents):

- LangChain 提供“代理(Agent)”机制,允许模型动态决定何时调用工具,例如搜索引擎、计算器等。

- 例如:构建一个金融助手,遇到复杂的财务计算时自动调用计算器工具。

✅ 模块化设计:

- LangChain 将各个功能模块化(如检索、生成、解析等),开发者可以灵活组合,快速搭建自定义工作流。

📖 2. RAG 的作用

RAG 是提升 LLM 性能的关键技术,尤其在处理大规模知识库或最新信息时,具有以下作用:

✅ 补充知识(Knowledge Injection):

- LLM 只知道它在训练时学到的知识,RAG 通过检索外部数据源(如数据库、文档库、网页等)来提供最新信息。

- 例如:在法律助手场景中,RAG 可以让 AI 访问最新的法律法规,而不局限于模型的固有知识。

✅ 减少幻觉(Hallucination):

- 直接从外部数据源提取信息,能降低 LLM“凭空捏造”的风险,让回答更准确可靠。

✅ 优化长文档处理:

- 当文档过长,无法一次性输入 LLM 时,RAG 能分段检索出相关片段,只让模型处理与问题相关的内容,大大提高效率。

✅ 动态更新知识库:

- 不需要重新训练模型,只需更新外部知识库,模型就能即刻访问新信息,保持知识“与时俱进”。

🚀 LangChain + RAG:完美搭档

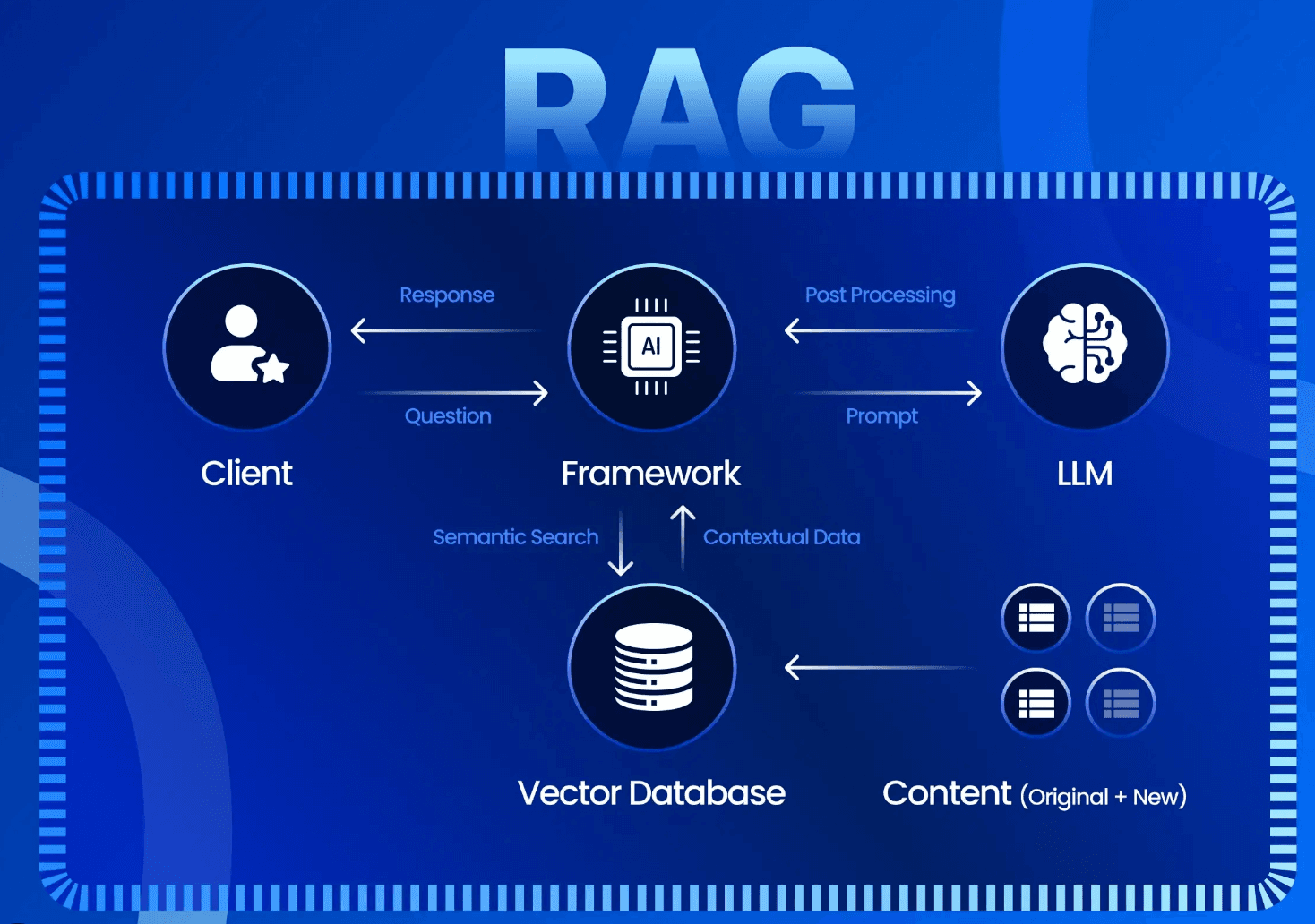

LangChain 提供了一套完整的工具链,帮你搭建 RAG 工作流,让 AI 具备动态检索外部知识的能力。典型的应用流程如下:

- 用户提问 →

- LangChain 调用检索模块(如向量数据库) →

- RAG 策略提取相关文档片段 →

- LangChain 把检索到的内容和用户问题一起传给 LLM →

- LLM 生成基于最新知识的回答。

常见场景:

- 企业内部知识库问答

- 客户支持自动化

- 法律、金融、医疗等领域的专业咨询

如果你希望构建更可靠、更实时的 AI 应用,LangChain 和 RAG 是不可或缺的工具!想要一段示例代码,或者具体的项目思路吗?✨